Kürzlich führte mich mein Weg nach Würzburg. Zahlreiche Lehrpersonen aller Schulformen kamen zusammen, um zwei Tage lang intensiv „Feedback als Schlüssel zum Lernerfolg: Ansätze und Methoden in Schule und Unterricht“ in den Blick zu nehmen. Die Arbeitstagung der Schulversuche „proof“ und „Prüfungskultur innovativ“ durfte ich für das bayerische Kultusministerium als Referent mitgestalten. Und schon das Planungskonzept machte offensichtlich: Die enge Verzahnung von Wissenschaft und Praxis ist eine entscheidende Voraussetzung, um eine positive Fehler- und Feedbackkultur in die Schulpraxis zu integrieren. Mit Prof. Maurice Fürstenberg ging es aus wissenschaftlicher Sicht fundiert in die Zusammenhänge von Aufgabengestaltung und Feedback, bevor ich den Rahmen praxisbezogen weiterspannte und Ansatzpunkte für Lernprozesse aufzeigte. Drei Teilsessions schlugen den Bogen, beginnend mit „Positive Fehler- und Feedbackkultur“ über „Feedback digital“ hin zu „Feedback – jetzt auch mit (generativer) KI?“.

Damit endeten wir bei einem aus meiner Sicht zentralen Entwicklungsfeld, wenn wir über (generative) KI in Lernprozessen sprechen, und der Frage: „Was verstehen wir eigentlich unter gutem Feedback – und wie können sowohl Lehrkräfte als auch KI-Systeme dazu beitragen?“

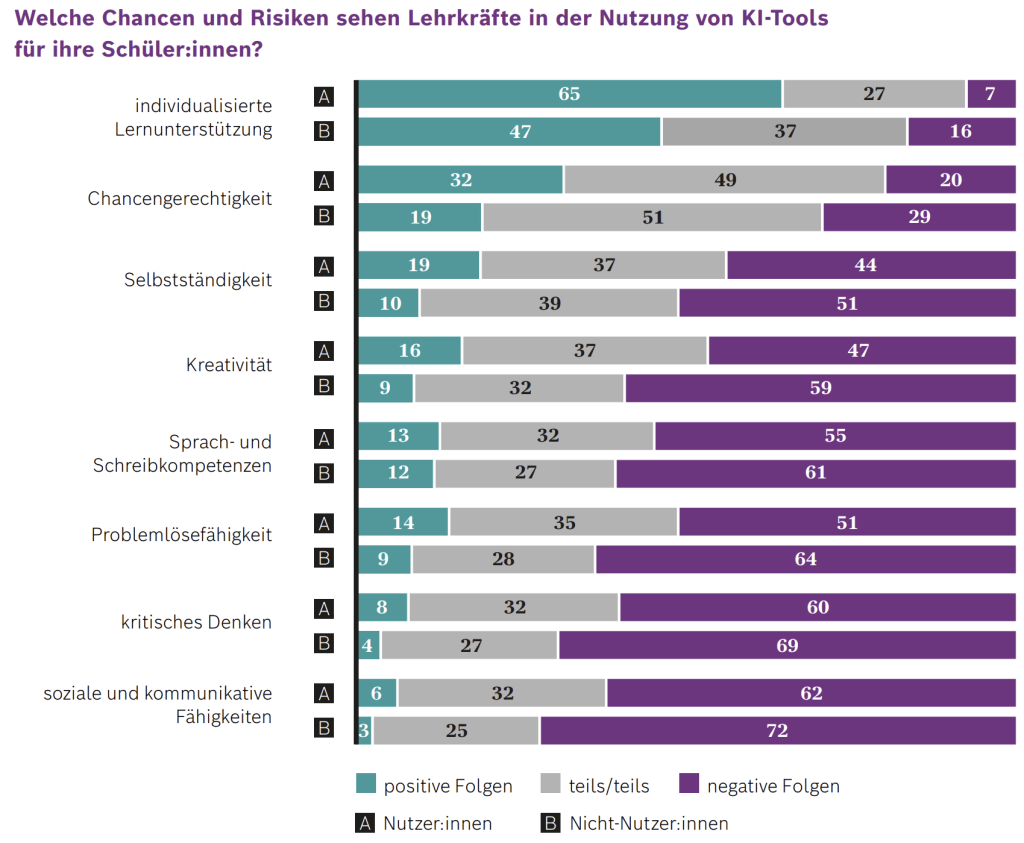

Und genau darum geht es auch in einer neuen Folge des Podcasts „Kompass KI“ mit Hendrik Haverkamp und Benedikt Wisniewski (Folge 7: KI-Feedback). Ich möchte unbedingt auch hier im Blog auf diese Folge verweisen und zugleich einige der Ergebnisse in unsere Schul- und Fortbildungspraxis einordnen, denn Studien wie die hier vorgestellte bieten uns wichtige Anhaltspunkte für kritische Reflexion. Zugleich zeigen alle Befragungen von Lehrpersonen, wie hier beispielhaft das Deutsche Schulbarometer 2025 der Robert Bosch Stiftung, dass aus professioneller Sicht (generative) KI gerade im Bereich der konstruktiven und individualisierten Lernunterstützung als besonders chancenreich angesehen wird. Interessant: Lehrpersonen, die bereits mit (generativer) KI arbeiten, bewerten das Potential höher als Lehrpersonen, die (generative) KI bislang nicht nutzen.

Was ist Feedback – und warum ist das mehr als „Gut gemacht“?

Doch zunächst zurück zum Podcast und der Studie: Am Anfang der Episode wird noch einmal sauber sortiert, worüber wir eigentlich sprechen. In der Forschung stellt Feedback nicht einfach irgendeine Rückmeldung dar, sondern beinhaltet Informationen zu Leistung oder Verständnis, die Lernenden helfen, ihr Lernen zu steuern.

Glücklicherweise verweist Benedikt Wisniewski gleich zu Beginn nochmal auf gängige Definitionen von Feedback (im Lernbereich): Kluger und Denisi beispielsweise, die in ihrer Meta-Studie zur Feedback Intervention Theory (S. 255 oben) betonen, Feedback sei eine Handlung, durch die jemand oder etwas Informationen über Aspekte der Leistung einer Person gibt. Eine andere einschlägige Definition liegt von Hattie und Timperley vor, denen zufolge Feedback aus Informationen besteht, die von einer Instanz über Aspekte der Leistung oder des Verständnisses gegeben werden (gut nachzulesen in einer Handreichung der Universität Mainz). Ganz ursprünglich meint „Feedback“ eine Rückkopplung: Informationen fließen zwischen zwei Instanzen, damit ein System sich regulieren kann.

In der pädagogischen Praxis wird der Begriff jedoch oft sehr großzügig verwendet. Fast jede Bemerkung – vom Smiley bis zur roten markierten Kritik – läuft unter „Feedback“, auch wenn sie weder an klaren Kriterien orientiert ist, noch tatsächlich eine Weiterarbeit an Aufgabe oder Lernprozess auslöst.

Wie problematisch das z.B. in Bezug auf die klassische Vollkorrektur von Klassenarbeiten und Klausuren sein kann, hatte ich vor einiger Zeit bereits im Blogbeitrag „Stoppt die Vollkorrektur!“ mit Blick auf die Studienlage und KI thematisiert.

Genau hier wird es spannend, wenn wir über KI-Feedback sprechen: Vergleichen wir wirklich „Feedback“ im fachlichen Sinn – oder nur verschiedene Varianten von Alltagsrückmeldungen?

Die zugrunde liegende Meta-Analyse: 41 Studien, 4.800 Lernende

Die Podcastfolge diskutiert eine Meta-Analyse mit dem Titel „How Does Artificial Intelligence Compare to Human Feedback?“ (2025). Meta-Analyse bedeutet: Viele einzelne Studien werden systematisch zusammengetragen und statistisch integriert. In diesem Fall waren es 41 Studien mit rund 4.800 Lernenden, überwiegend aus dem Bereich Schreiben und Sprache. Verglichen wurden jeweils Feedback durch KI und Feedback durch Menschen – also Lehrende oder Peers.

Da die einzelnen Studien mit sehr unterschiedlichen Designs, Stichproben und Messinstrumenten gearbeitet haben, nutzte das Forschungsteam ein sogenanntes Random-Effects-Modell. Vereinfacht gesagt geht man dabei davon aus, dass Effekte je nach Kontext variieren und modelliert diese Unterschiede statistisch mit. Auf dieser Basis wollten die Forschenden vier zentrale Fragen beantworten:

-

- Lernt man mit KI-Feedback besser oder schlechter als mit menschlichem Feedback?

- Wie wird das Feedback wahrgenommen?

- Was passiert mit Motivation und Engagement?

- Und hat eine Kombination aus Mensch und KI besondere Vorteile?

Die Ergebnisse: Kein klarer Sieger – aber ein wichtiges „Es ist anders“

Das vermutlich überraschendste Ergebnis: Es gibt keinen klaren Gewinner. Hinsichtlich der Lernleistung zeigen die zusammengefassten Studien keinen signifikanten Unterschied zwischen KI-Feedback und menschlichem Feedback. Lernende lernen im Durchschnitt also nicht schlechter, aber auch nicht besser, wenn das Feedback von einer KI statt von einer Lehrkraft oder Mitstudierenden kommt.

Ähnlich sieht es bei der Wahrnehmung des Feedbacks aus. Lernende bewerten das KI-Feedback nicht signifikant anders als menschliche Rückmeldungen – weder in Bezug auf Klarheit noch auf Nützlichkeit. Die gern geäußerte These, KI-Feedback sei grundsätzlich oberflächlich, unspezifisch oder „weniger wert“, findet so pauschal – das konstatieren auch Wisniewski und Haverkamp – in den Daten keine Bestätigung.

Gleichzeitig wird deutlich, warum KI-Feedback dennoch oft als begrenzt erlebt wird: Die meisten untersuchten Systeme waren regelbasiert und konzentrierten sich vor allem auf formale Aspekte wie Grammatik, Satzbau oder Wortwahl. Dort arbeitet (generative) KI konsistent, verlässlich und erstaunlich präzise – aber naturgemäß auf der Oberfläche. Für inhaltliche, argumentative oder konzeptuelle Rückmeldungen fehlt vielen Systemen das kontextuelle und semantische Tiefenverständnis, das wir von guter fachlicher Rückmeldung erwarten. Die Forschenden bringen es deshalb klug auf den Punkt: KI-Feedback ist nicht schlechter, es ist anders. Es deckt bestimmte Ebenen sehr gut ab und lässt andere offen.

Das deckt sich übrigens auch mit der Kernaussagen eines sehr hilfreichen Basisbeitrags aus „Der Deutschunterricht“ 05/2024, in dem Prof. Maurice Fürstenberg und Prof. Hans-Georg Müller konstatieren: „Die große Chance, die GPTs für die Deutschdidaktik bieten, liegt damit nicht im sprachlichen Inhalt, sondern v. a. in der sprachlichen Form, die von aktuellen Modellen in einer verblüffend adäquaten Weise repräsentiert, reproduziert und variiert werden kann. Sprachmodelle lernen in ihrer Trainingsphase sprachformale Muster, deren Beherrschung auch von Schüler:innen erwartet wird, etwa in der Orthografie, der Morphosyntax, der Textsorte oder den sprachlichen Registern.“ Daher plädieren auch sie für (generative) KI als (Feedback-)Tutor oder Sparringspartner, nicht aber als „Taschenrechner“.

Bei Motivation und Engagement fällt das Bild weniger klar aus. Hier sind die Studien so heterogen und teils so dünn, dass sich keine robuste Gesamtzahl berechnen lässt. Qualitativ zeigt sich aber, dass Lernende KI-Feedback häufig als neutral, kontrollierbar und entlastend erleben – gerade weil sie in ihrem eigenen Tempo nachbessern können, ohne soziale Bewertungssituationen aushalten zu müssen.

Hier ist die Podcast-Folge besonders interessant, wenn der nüchtern operierende „Statistiker“ Benedikt Wisniewski auf den „4K-Lehrer“ Hendrik Haverkamp trifft und sich einmal mehr zeigt: Nicht jede subjektiv entwickelte Theorie von uns Lehrpersonen lässt sich tatsächlich datenbasiert halten, aber auch nicht jedes quantitativ gemessene Studienergebnis gibt tatsächlich die Lernrealität(en) vieler Kinder und Jugendlicher wieder. Und da lohnt sich der Blick in das Studiendesign; Zeit für Benedikt Wisniewski.

Methodische Stärken und Schwächen: Solide Meta-Analyse, wackelige Basis

Im Podcast beschreibt Wisniewski die Meta-Analyse selbst als methodisch solide beschrieben: breite Datenbasis, transparentes Vorgehen, sinnvolle statistische Integration. Aber – und das ist für uns in der Praxis wichtig – eine Meta-Analyse ist immer nur so gut wie die Studien, aus denen sie besteht.

Und hier zeigen sich offensichtlich deutliche Schwächen (die mir beim Blick in die Ergebnisse nicht offensichtlich waren): In einigen Primärstudien war unklar, welche KI-Systeme überhaupt eingesetzt wurden. Versuchsdesigns blieben teilweise unkontrolliert, und als Qualitätsindikator wurden zum Teil fragwürdige Maße wie „Feedback-Likes“ verwendet. Hinzu kommt, dass viele der untersuchten Systeme technisch längst überholt sind und mit heutigen generativen KI-Modellen nur noch bedingt vergleichbar. Fast alle Studien stammen zudem aus dem Bereich Schreiben und Sprache; naturwissenschaftliche, mathematische oder berufsbezogene Kontexte sind kaum abgebildet.

Für uns heißt das: Die Befunde sind relevant und wegweisend, aber sie sollten mit Augenmaß übertragen werden – insbesondere auf aktuelle KI-Systeme und auf Unterrichtsfächer, die in den Studien gar nicht vorkommen.

Was bedeutet das für Schule und Unterricht?

Trotz aller Einschränkungen ist eine zentrale bildungspolitische und schulpraktische Botschaft deutlich: KI ersetzt Lehrkräfte nicht, sondern ergänzt sie. Gerade im schulischen Alltag bekommen Lernende oft zu wenig individuelles, lernwirksames Feedback, meist schlicht aus Zeitgründen, sicherlich aber auch aufgrund mangelnder Professionalisierung. Dennoch: Eine Lehrkraft mit 25 bis 30 Schülerinnen und Schülern je Lerngruppe (und davon 3-4 am Tag bei voller Stelle) kann nicht allen Lernenden regelmäßig qualitativ hochwertige Rückmeldungen auf Texte, Präsentationen oder Lösungswege geben.

Hier eröffnet (generative) KI schon jetzt einen realistischen Ausweg: Die Technik kann jederzeit, in Echtzeit und beliebig oft Rückmeldungen geben – also Feedback gewissermaßen skalierbar machen. Besonders bei klar definierbaren Kriterien (Sprache, Struktur, Format, bestimmte formale Anforderungen) kann generative KI eine enorme Entlastung sein. Die Lehrkraft muss nicht mehr jedes Komma korrigieren, sondern kann ihre Zeit auf diejenigen Aspekte fokussieren, die menschliches Urteil, pädagogische Sensibilität und Kontextwissen erfordern: die Qualität eines Arguments, die Passung eines Lösungsweges, die Förderung von Reflexion und Metakognition, das Begleiten individueller Lernbiografien.

Hinzu kommt ein wichtiger sozialpsychologischer Aspekt, den die beiden Podcast-Hosts ebenfalls betonen: Gerade psychisch belastete oder sehr zurückhaltende Schülerinnen und Schüler holen sich häufig kein Feedback bei der Lehrkraft oder bei Peers – aus Scham, Unsicherheit oder Angst vor Bewertung. KI-Feedback kann hier ein niedrigschwelliger Zugang sein, weil die soziale „Bedrohung“ wegfällt. Gleichzeitig bleibt die Lehrkraft als „sichere Person“ wichtig, um diese Prozesse zu rahmen, zu reflektieren und zu begleiten.

So ziele ich in Fortbildungen gerne auf ein differenziertes Verständnis von KI-Feedback ab, das momentan meist die drei Bereiche

-

- KI-basierte Textüberarbeitung,

- individuelle Tutorsysteme und

- Aufgabenmanagement mit (generativer) KI

umfasst und exemplarisch mit konkreten Prompts oder Tools die Möglichkeiten und Grenzen generativer KI auszuloten hilft. Ein Beispiel für „Aufgabenmanagement“ bzw. lernförderliches Feedback im Arbeitsprozess ist die Plattform FelloFish, die von Hendrik Haverkamp und Malte Hecht entwickelt wurde und mithilfe derer Lehrpersonen wie Lernende schon jetzt Erfahrungen mit KI-Feedback sammeln können.

Und hier kommen die Studie und die (ganz subjektiven) Unterrichtserfahrungen der letzten Jahre zusammen: Denn alle im Podcast vorgestellten bzw. in der Studie nachlesbaren Erkenntnisse decken sich mit den vielen Eindrücken aus Schule und Unterricht und dem Feedback der Lernenden.

In der idealtypischen Perspektive entsteht demnach ein hybrides Modell: KI übernimmt die repetitive, formale und skalierbare Feedbackarbeit, Lehrkräfte bringen Empathie, Ermutigung, Beziehungsarbeit und tiefes fachliches sowie pädagogisches Verständnis ein – und korrigieren zugleich, wenn KI falsch liegt. Die Meta-Analyse liefert erste Hinweise darauf, dass genau diese Kombination in Zukunft wirksamer sein könnte als eine der beiden Seiten allein.

Der unbequeme Punkt: Wie gut ist unser menschliches Feedback eigentlich?

Zum Schluss stellt der Podcast eine Frage, die ich persönlich für die wichtigste halte: Wenn KI-Feedback und menschliches Feedback in den Studien so ähnlich abschneiden – liegt das nur daran, dass KI so „gut“ geworden ist? Oder auch daran, dass unser Feedback als Lehrkräfte oft weniger professionell ist, als wir glauben?

Wie viel evidenzbasierte Feedbackkompetenz taucht tatsächlich in Lehramtsstudium, Referendariat und Fortbildungen auf – jenseits von Alltagsideen und populären, aber empirisch fragwürdigen Modellen wie dem „Feedback-Sandwich“, das Benedikt Wisniewski am Ende doch tatsächlich aus der methodischen Mottenkiste holt?

In der Episode wird vorgeschlagen, einmal fünf frisch ausgebildete Lehrkräfte zu fragen, was sie im Rahmen ihrer Ausbildung wirklich fundiert über professionelles Feedback gelernt haben. Die implizite Wette: Die Antworten werden eher dünn ausfallen.

Genau hier liegt für mich eine große Chance: Die Diskussion um KI-Feedback kann ein Hebel sein, um Feedback insgesamt zu professionalisieren – in Fachseminaren, Studienseminaren und Fortbildungen.

Statt nur die Frage zu stellen: „Darf KI das?“, könnten wir sie nutzen, um zu klären: „Was verstehen wir eigentlich unter gutem Feedback – und wie können sowohl Lehrkräfte als auch KI-Systeme dazu beitragen?“

Für mich bleibt mit Blick auf die Studienergebnisse und nach dieser Podcastfolge vor allem eins hängen: KI-Feedback ist nicht der „böse Ersatz“ für Lehrpersonen oder Symptom einer entmenschlichten Input-Output-Orientierung, sondern ein Werkzeug, das uns dazu zwingt, genauer über unser eigenes professionelles Handeln nachzudenken. Wenn wir es klug nutzen, kann es uns entlasten, Lernenden neue Zugänge eröffnen und gleichzeitig die Diskussion über gutes, wirksames Feedback in Ausbildung und Fortbildung voranbringen.

Hoffen wir das Beste! 😉