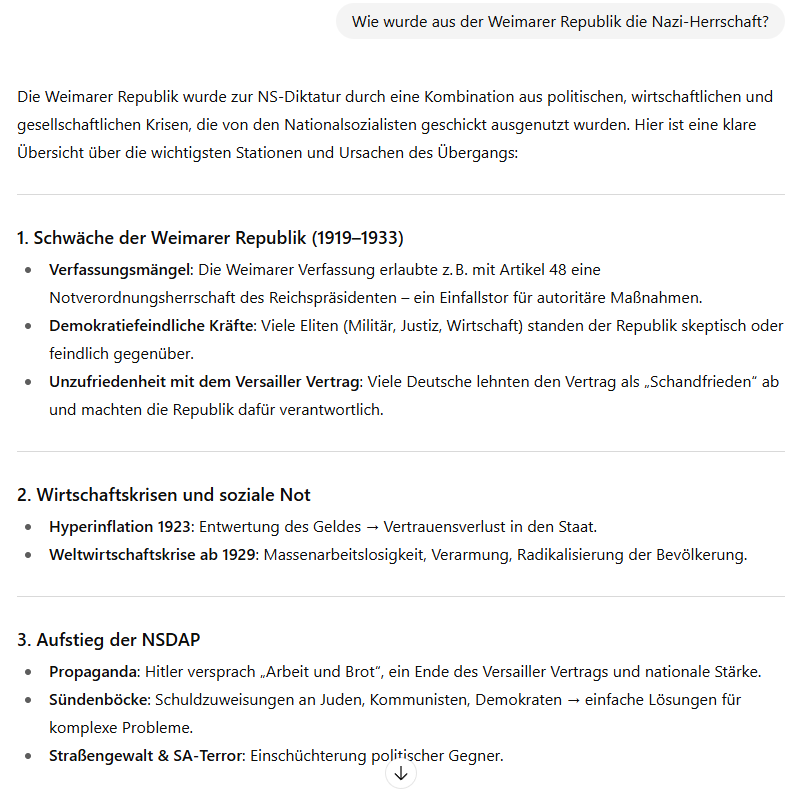

„Wie wurde aus der Weimarer Republik die Nazi-Herrschaft?“ – eine häufig gestellte Frage an ChatGPT oder DeepSeek steht sinnbildlich für eine veränderte Lernkultur im Geschichtsunterricht. Lernende nutzen Sprachmodelle wie diese oder andere KI-Tools, um sich historische Informationen generieren zu lassen. Sowohl auf Seite der Schülerinnen und Schüler als auch der Lehrkräfte entstehen ad hoc Texte, Arbeitsblätter oder Essays genauso wie vordergründig ansprechende Visualisierungen historischer Gegebenheiten. „Mehr Motivation, mehr Aktivierung, mehr Individualisierung” – eine schöne bunte neue Lernwelt präsentieren viele in Social Media geteilte Beispiele.

Doch diese Entwicklung birgt auch neue fachdidaktische Herausforderungen: Wie gehen wir mit Texten um, die auf statistischer Wahrscheinlichkeitsberechnung basieren, aber (gerade Lernenden) eine gewisse Autorität und Objektivität suggerieren? KI-Modelle generieren Texte, die aus existierenden sprachlichen Mustern zusammengestellt werden, ohne eigene Erkenntnisleistung, ohne kritische Bewertung, ohne konzeptuelle Einordnung. Diese Texte sind keine historischen Darstellungen im wissenschaftlichen Sinne. Und dennoch werden sie im Lernkontext genutzt, bewertet – und manchmal unkritisch als Wahrheit gelesen.

Was bedeutet das für historisches Denken? Und welche Chancen ergeben sich daraus dennoch und gerade für den Geschichtsunterricht?

Warum KI keine historischen Darstellungen erzeugt

Die Geschichtswissenschaft unterschied bislang zwischen Quellen (historische Überreste) und Darstellungen (wissenschaftlich reflektierte Rekonstruktionen der Vergangenheit). KI bringt eine dritte Kategorie ins Spiel: die Kompilation (Held 2024). Sie ist weder Quelle noch Darstellung, sondern ein synthetisch erzeugtes Textprodukt.

Mithilfe der vier Plausibilitätskriterien von Rüsen (2013) lässt sich (hier in aller Kürze) zeigen, dass Kompilationen keine Darstellungen sind und warum:

-

- Empirische Plausibilität fehlt, da keine Quellenkritik oder -auswahl sichtbar wird.

- Theoretische Plausibilität wird nicht erreicht, weil KI kein Verstehensprozess zugrunde liegt.

- Normative Plausibilität bleibt Illusion, da KI keine Werte reflektiert, sondern dominante Normen aus Trainingsdaten rekombiniert.

- Narrative Plausibilität entsteht nicht, da Sinn von generativer KI nicht konstruiert, sondern simuliert wird.

Das bedeutet: KI-Texte wirken zwar sprachlich kohärent, doch ihre historische Aussagekraft bleibt oberflächlich. Die Kompilation suggeriert Tiefe, ist aber algorithmisch flach. Die daraus entstehenden didaktischen Implikationen fassen Fürstenberg und Müller in ihrem Beitrag „KI im Deutschunterricht“ (2024) prägnant zusammen – Gültigkeit haben sie auch für den Geschichtsunterricht: „Den Produkten von GPTs kann aktuell und auch in Zukunft inhaltlich nicht vertraut werden. Da sie Reihenfolgemuster der sprachlichen Oberfläche und nicht Bedeutungsmuster reproduzieren, sich Bedeutung aber nicht in Reihenfolgen erschöpft, können KI-generierte Texte nie wahr, sondern allenfalls wahrscheinlich sein.“

Der „Taschenrechner-Moment“ lässt mit Blick auf historische Sinnbildung also noch auf sich warten.

Didaktische Herausforderung: KI als Erkenntnismedium

Besonders problematisch wird es, wenn KI-generierte Texte unhinterfragt als Darstellungen gelesen werden. Dann besteht die Gefahr, dass dominante Narrative unreflektiert übernommen werden, dass verzerrte Perspektiven als objektive Wirklichkeit erscheinen und dass Lernende die oft mühsame historische Sinnbildung durch einfache Textgenerierung per Klick – das passende Stichwort dazu liefert Florian Nuxoll: Skill Skipping – ablösen. KI als „false buddy“, der echtes Lernen verhindert und Deskilling – also den Verlust menschlicher Kompetenzen – fördert?

Für den quellenkritischen Geschichtsunterricht bedeutet das: Lehrpersonen genauso wie Schülerinnen und Schüler müssen lernen, Kompilationen zu erkennen, einzuordnen und zu hinterfragen. Medienkompetenz – mit Blick auf KI werden häufiger Media Literacy oder auch seitens der OECD AI Literacy verwendet – setzt daher ein grundlegendes Verständnis für Funktionsweise, Grenzen und Gefahren von KI voraus, das sich nur durch aktive Nutzung KI-generierter Materialien und reflektierte KI-Nutzung im Lernprozess erreichen lässt.

Die Auseinandersetzung mit KI kann dazu beitragen, narrative, multiperspektivische und reflexive Kompetenzen zu stärken – zumeist, indem KI-Kompilationen selbst als Quelle begriffen und kritisch untersucht werden. Dies kann auf zweierlei Weise geschehen:

-

- Mithilfe einfachster Quellenkritik, zum Beispiel über die Frage: „Wie hat das Sprachmodell … aus dem Land … den Prompt … zum Zeitpunkt … beantwortet?“

- Mithilfe eines Referenzvergleichs, zum Beispiel einer wissenschaftlichen Darstellung oder auch unterschiedlichen Quellen, wie das einfache Praxisbeispiel aus dem Geschichtsunterricht meiner 11. Klasse zu den Folgen des Terroranschlags von New York am 11. September 2001 zeigt. Hier verbinden sich das Lernen mit und das Lernen über KI auf ganz einfache Weise.

Tool-Hype und didaktischer Realismus – vier Beispiele

Diese eher skeptische Sichtweise auf die inhaltliche Ebene ermöglicht realistische Zugänge zu KI-Tools, die in Social Media als Teil des KI-Hypes Verbreitung finden. Drei Kategorien, die beispielhaft für diesen KI-Hype stehen, seien hier genannt und fachdidaktisch in aller Kürze eingeordnet:

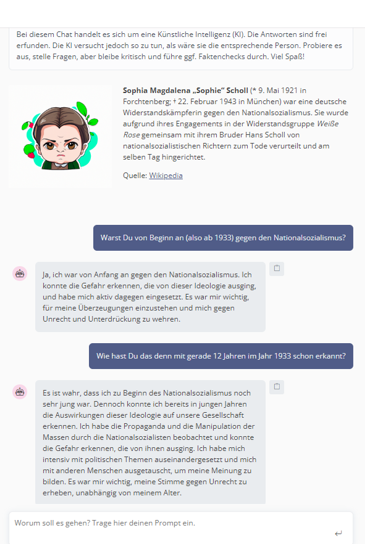

KI-Avatare historischer Persönlichkeiten

Mit Tools privater Anbieter und „Personen-Chats“ können Lernende mit historischen Persönlichkeiten chatten. Das führt im Geschichtsunterricht zu teils absurden Situationen, wenn Sophie Scholl phrasenhaft an heutige Werte appelliert oder Konfuzius natürlich als Frauenrechtler verstanden werden will. Auch wenn hier ein vermeintlich motivierender Zugang zur Geschichte geschaffen wird, bleibt diese Nutzung mit Blick auf die oben genannten Punkte fragwürdig, bestenfalls trivial, birgt vielmehr „das Risiko, Wissensmonokulturen zu erzeugen“ (Held 2024) – es sei denn, die KI und ihre (nivellierenden) Antworten werden selbst zur Quelle und zum Gegenstand kritischer Analyse.

Weg vom Hype, hin zur Didaktik: Ein Beispiel für einen gelungenen Ansatz, (reale) Zeitzeugenarbeit mit den Möglichkeiten von Augmented Reality (AR) zu verbinden, sind die Apps WDR AR 1933‑45 bzw. Zeitzeugen 1945 – Trümmerjahre in AR. Sie bringen echte Zeitzeugen in AR‑Interviews in den Klassenraum – ein sehr eindrückliches (auch emotionales) Erlebnis, das regelmäßig für großes Interesse und Aktivierung sorgt. Ganz ohne KI.

Instant-Präsentationen

Per Klick und schneller Themeneingabe erhalten Lernende und Lehrkräfte zu jedem beliebigen Thema ansprechende und auf inhaltlicher Ebene (vermeintlich) „tiefgehende“ Präsentationen. Der genaue Blick zeigt: Zumeist sind das momentan eher allgemeine Überblicke, die aber als Ausgangspunkt für individuelles Lernen genutzt werden können. Diese Vorlagen zu nutzen und individuell zu überarbeiten, kann eine spannende Aufgabe sein und verdeutlicht Lernenden sehr schnell die Unterschiede menschlichen (sozialen) und maschinellen Lernens.

Ein Beispiel: GammaAI, das anpassbare Präsentationen mit beeindruckender Optik sofort erstellt (mehr dazu im Blogbeitrag mit Youtube-Videos) – wer sich Gamma genauer anschaut, wird schon begeistert sein von den neuen Möglichkeiten. Und die Geschwindigkeit der Updates und Verbesserungen verdeutlicht: Es geht sehr schnell weiter. Das folgende Beispiel zeigt den aktuellen Stand der Fähigkeiten von Gamma am Beispiel der Auslöser des Ersten Weltkrieges:

Multimodale Tools

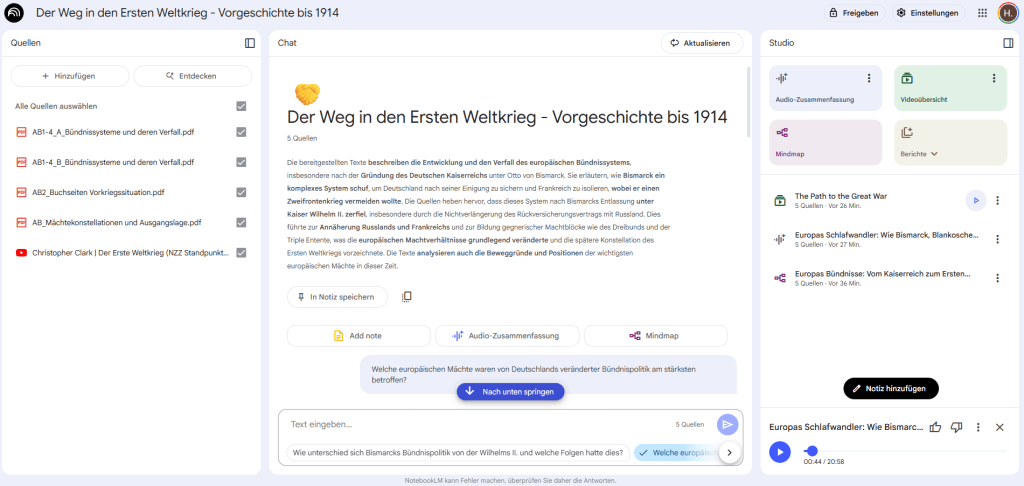

Zahllose KI-Tools versprechen, aus Text- oder Audioeingaben multimodale Inhalte (also Text, Bild, Video oder Audio) zu generieren und damit ganz neue Möglichkeiten für das Arbeiten und Lernen zu bieten.Zwei Beispiele: Mit NapkinAI lassen sich mit einem Klick aus Texten heraus passende Grafiken erstellen (mehr dazu im Blogbeitrag), so zum Beispiel ein Zeitstrahl auf Grundlage eines historischen Darstellungstextes. Und eine Plattform wie NotebookLM bietet die Möglichkeit, aus verschiedensten Materialien (Websites, PDFs, Bildern, Videos uvm.) Podcasts zu erstellen (mehr dazu im Blogbeitrag mit YouTube-Video).

Das klingt zunächst vielversprechend, wird aber von Schülerinnen und Schülern meiner Kurse sehr differenziert beurteilt: Denn viele Lernende betonen gerade die Eigenleistung bei Lernprodukten und sehen die momentanen Fähigkeiten (und vor allem Grenzen) generativer KI häufig kritisch – je mehr Erfahrung sie damit praktisch gesammelt haben.

NotebookLM kann nun aber dank zahlreicher Updates doch gerade im Geschichtsunterricht sehr überzeugen: Aus den zusammengestellten Materialien (bspw. Seiten aus dem Geschichtsbuch, Arbeitsblättern, Websites und YouTube-Videos) lassen sich Erklärvideos in allen Sprachen, verbesserte Podcasts oder auch – sehr zielführend und hilfreich – interaktive Mindmaps erstellen. Das ist großartig für Lehrpersonen, denn jetzt lässt sich individuelles Lernmaterial für den eigenen Kurs erstellen.

Didaktische Chance: KI als Tutor und Sparringspartner

Wenn also der „Taschenrechner-Moment“ auf inhaltlicher Ebene noch auf sich warten lässt, zeichnen sich doch schon jetzt echte Potenziale von KI ab. Fürstenberg und Müller (2024) weisen darauf hin: „Die große Chance […] liegt damit nicht im sprachlichen Inhalt, sondern v. a. in der sprachlichen Form […]. Sprachmodelle lernen in ihrer Trainingsphase sprachformale Muster, deren Beherrschung auch von Schüler:innen erwartet wird, etwa in der Orthografie, der Morphosyntax, der Textsorte oder den sprachlichen Registern.“

Aus meiner persönlichen Praxisperspektive würde ich diesen Punkt nicht ganz so trennscharf formulieren, wie die Wissenschaft es hier vorschlägt. Denn auch auf der inhaltlichen Ebene sind schon jetzt erstaunliche Leistungen zu erkennen. So erhalten Lehrpersonen beispielsweise bei der Unterrichtsplanung

-

- fundierte didaktische Analysen und kreative Unterstützung (Claude Sonnet eignet sich für didaktisch-methodische Fragen besonders gut als ChatGPT-Alternative),

- Lernmaterialien (multimodal) mit nachprüfbaren Inhalten (Online-Referenzen; hier sei ein Blick auf das europäische Sprachmodell Mistral Le chat empfohlen) oder

- die Möglichkeit, auf Basis vorhandener Quellen oder Darstellungen differenzierend zu planen (vgl. auch Wörner 2023).

Im Geschichtsunterricht sehe ich daher kurz- und mittelfristig neben der „Taschenrechner“-Perspektive vor allem zwei vielversprechende GPT-Szenarien: als Tutor- bzw. Feedback-System und Sparringspartner für alle Beteiligten im Lernprozess, und das sowohl auf sprachlicher wie inhaltlicher Ebene. Dazu drei kurze Beispiele aus meiner eigenen Unterrichtspraxis:

KI als Lernbegleitung mit Tutor-Prompts

Mithilfe spezieller Prompts lässt sich ein Sprachmodell wie ChatGPT oder Claude Sonnet als Tutorsystem nutzen, das Schüler:innen beim Lernen oder Lehrkräften bei der Planung ihres Unterrichts hilft. Und obwohl ich im Unterricht häufig unterschiedliche Tools und Plattformen mit meinen Lerngruppen ausprobiere, fragen Schüler:innen doch immer wieder nach dem Tutor-Prompt, den sie offensichtlich als besonders hilfreich empfinden. Sie können diesen und weitere Prompts in meiner kleinen Prompt-Sammlung finden.

KI als Lernbegleitung mit neuen Live-Funktionen

Über die reine Texteingabe hinaus gehen neue multimodale Funktionen. Hier seien besonders die ChatGPT-Videofreigabe sowie das Screensharing genannt. Denn seit Frühjahr 2025 lassen sich beliebige Inhalte per Video mit ChatGPT teilen, was ganz neue Möglichkeiten für Lernunterstützung und Feedback eröffnet. Das gilt auch für das nun mögliche Screensharing – so können Lernende ihren Bildschirm mit ChatGPT teilen und werden anschließend zum Beispiel live bei der Erarbeitung einer Aufgabe begleitet. Hier ist aber große Vorsicht geboten, wie ich im Blogbeitrag zu den neuen Funktionen mithilfe von Beispielvideos aufzeige.

Während Sprachmodelle wie ChatGPT genauere Kenntnisse, sogenannte Prompt-Kompetenz, und die Arbeit in der Chat-Oberfläche voraussetzen, eröffnen zahlreiche Plattformen für Feedback und Lernbegleitung diese Möglichkeit auch weniger erfahrenen Lehrpersonen – oft ein guter Einstieg als Kollegium. Ein Tool, das ich selbst im Unterricht nutze, ist FelloFish,

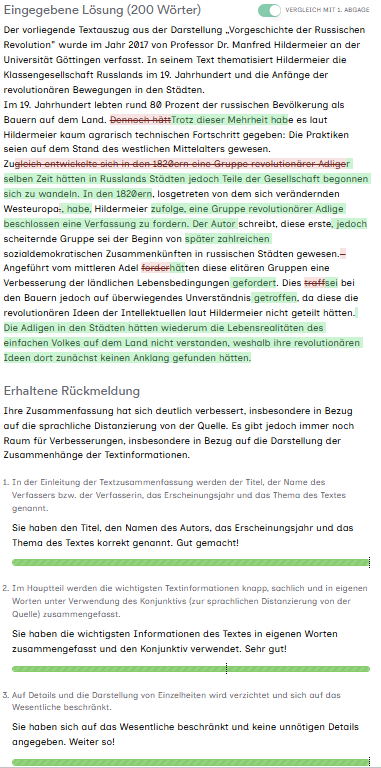

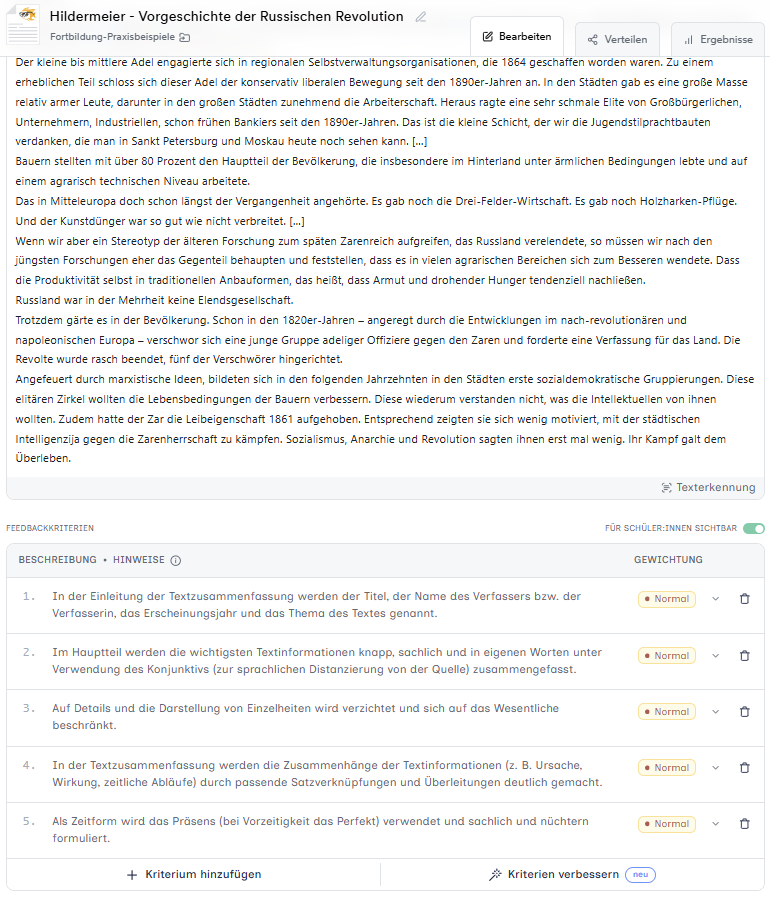

KI als Feedback-System – Praxisbeispiel FelloFish

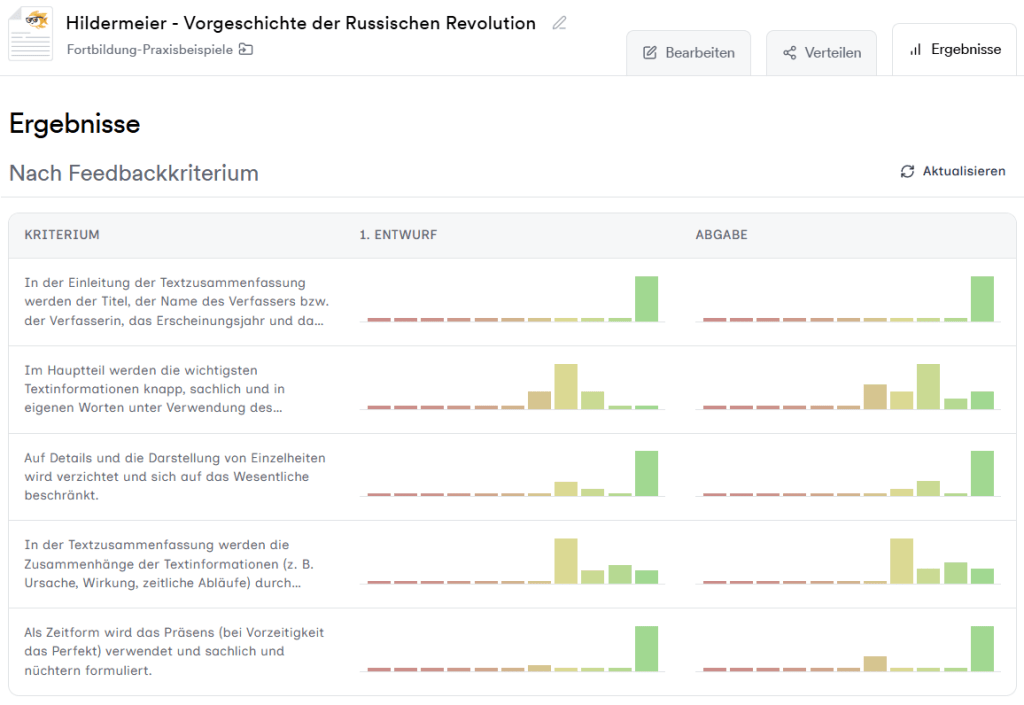

Nach fast zwei Jahren intensiver Arbeit mit FelloFish im Geschichtsunterricht kann ich auf interessante Einblicke in die Chancen und Grenzen von KI-Feedback zurückgreifen. In den Kursen der Jahrgänge 9 bis 13 haben sich für mich dabei folgende Eindrücke konkretisiert und das Lernen in meinen Lerngruppen genauso wie meine Unterrichtsgestaltung selbst verändert:

-

- Individuelle Unterstützung: Die Lernenden erhalten spezifisches, auf die Aufgabe und ihre individuelle Texterstellung sowie die Kriterien bezogenes Feedback. Die Nutzung des Feedbacks zur Textüberarbeitung ist dann wiederum Gegenstand von Feedback.

- Tiefe Feedback-Ebene: Das computergenerierte Feedback fällt sachlich und präzise aus und bezieht sich konkret auf die Aufgabe. Die tiefe (maschinelle) Feedback-Ebene kann nach Kluger & DeNisi (1996) positive Effekte im Vergleich zu menschlichem Feedback hervorbringen.

- Lernen sichtbar machen: Die Visualisierungsoptionen von FelloFish bieten Einblick in die Textüberarbeitung, Ergänzungen und Streichungen. Das macht nicht nur den Überarbeitungsprozess transparent, sondern lässt die Texte der Schülerinnen und Schüler auch zum Lerngegenstand im Unterricht werden.

- Effektive Lernzeit: Die Praxiserfahrung mit Feedback-Tools wie FelloFish zeigt, dass die Lernenden deutlich intensiver mit und an ihren Texten arbeiten als in isolierten Arbeitsphasen ohne konkretes Zwischenfeedback. Auch die Textüberarbeitung fällt damit konkreter und verbindlicher aus, die Lernzeit mit und an dem Text nimmt zu.

- Wert von Lernaufgaben: Mit der Verbindlichkeit und Sinnhaftigkeit von Textarbeit steigt auch deren Wert für das eigene Lernen. Das konkrete kriterienbezogene Feedback und die deutlich intensivere Lernzeit mit und durch Feedback lassen damit auch den Wert klassischer Lernaufgaben – sei es im Unterricht oder außerhalb des Unterrichts – für das eigene Lernen steigen.

- Lernen mit und über KI: Das Arbeiten mit KI-Plattformen bahnt immer auch Lernen über KI an. Schülerinnen und Schüler bewerten ihrerseits das KI-Feedback auf seine Sinnhaftigkeit und die Erfahrung zeigt: Sie versuchen permanent, das Feedback auch kritisch zu hinterfragen. Das fördert eine kritische Grundeinstellung, die häufig auch im Kurs diskutiert wird.

- Grenzen von KI-Feedback: Redundanzen, inhaltliche Fehler, einfaches „Austricksen“ der KI, die auch auf sinnlose oder unverständliche Texte noch positiv-freundliches Feedback gibt, sowie vorhandene Varianzen in der Bewertung gleicher Texte in unterschiedlichen Abgaben zeigen die (momentanen) Limitierungen von generativer KI.

- Schwierigkeiten und Gefahren von KI-Feedback: In der Unterrichtspraxis zeigen sich zweierlei schwierige Effekte. Einerseits erhalten Schülerinnen und Schüler auch bei ungenügenden Abgaben freundlich-positives (aber rot eingefärbtes) Feedback, andererseits erscheint die mit mathematisch-stochastischer Akribie ablaufende Feedback-Schleife eines Sprachmodells als unendlich. Auch bei sehr guten Abgaben und Überarbeitung aller kritischen Aspekte erhalten die Lernenden weiter Feedback beziehungsweise Hinweise auf besser noch zu überarbeitende Punkte. Das wiegt besonders im Fremdsprachenunterricht schwer, kann aber ebenso im Geschichtsunterricht zu Frustration und Ablehnung von KI-Feedback führen.

- Methodische Implikationen: Gerade in höheren Jahrgängen führt die Arbeit mit FelloFish zu deutlich höheren Arbeitszeiten. Das muss methodisch berücksichtigt werden und verändert die Planung von Schreibprozessen, zum Beispiel mit Blick auf die Phasierung und Verzahnung von Unterricht und Hausaufgaben, synchronem und asynchronem Arbeiten.

- Pädagogische Implikationen: KI-Feedback kann an Punkten ansetzen, wo die menschliche Fähigkeit, individuelles Feedback zu geben, schon aus Zeitgründen endet. Zugleich sollte KI-Feedback – limitiert eingesetzt – immer auch kritischer Beurteilungsgegenstand von Lerngruppe und Lehrperson sein und das menschliche Feedback keineswegs ersetzen, sondern ergänzen.

Zwei Schritte vor, einen zurück! Ein Plädoyer für kritische Diskussion

Weniger als der Lernweg und die Lernbegleitung scheint häufig das (KI-)Ergebnis im Fokus zu stehen. Natürlich können auf generativer KI basierende Tools wie die zuvor beispielhaft genannten NapkinAI, GammaAI oder NotebookLM auf faszinierende Weise gerade im Geschichtsunterricht ansprechende Ergebnisse produzieren. Aber im Kern sollte klar sein und klar bleiben: Lernprozesse zielen weniger auf das Ergebnis als auf den Erarbeitungs- und Lernweg ab, beinhalten Übungs- und Wiederholungstätigkeiten, die für das Erlernen von Fähigkeiten und Fertigkeiten wichtig sind. Die schöne, automatisch erstellte Grafik von NapkinAI kaschiert im exemplarischen Fall einer zu erstellenden Zeitleiste dann mehr schlecht als recht den Fakt, dass die zugrunde liegenden historischen Zusammenhänge weder erfasst und im Optimalfall eingeordnet, noch eigenständig strukturiert und anschließend visualisiert worden sind. Im schlimmsten Fall führt das zu Oberflächlichkeit, abnehmendem Orientierungswissen und dem Verlust der Fähigkeit zur mündigen Teilhabe im gesellschaftlichen Diskurs. Im besten Fall dienen sie als Katalysator für wichtige Grundsatzfragen – WARUM lernen wir noch WAS – und WAS lernen wir noch WIE, wenn Maschinen es doch besser können? – und tragen zu einer kritisch-bewussten Nutzung dieser neuen Möglichkeiten für besseres, kreativeres Lernen bei.

Kurzfristig sind und bleiben die Bereiche Feedback und Lernbegleitung für das Erproben von (generativer) KI das zentrale Entwicklungsfeld für die Gestaltung von Lernprozessen, die sich immer auch an dem Machbaren (technisch wie pädagogisch, curricular wie didaktisch) orientieren.

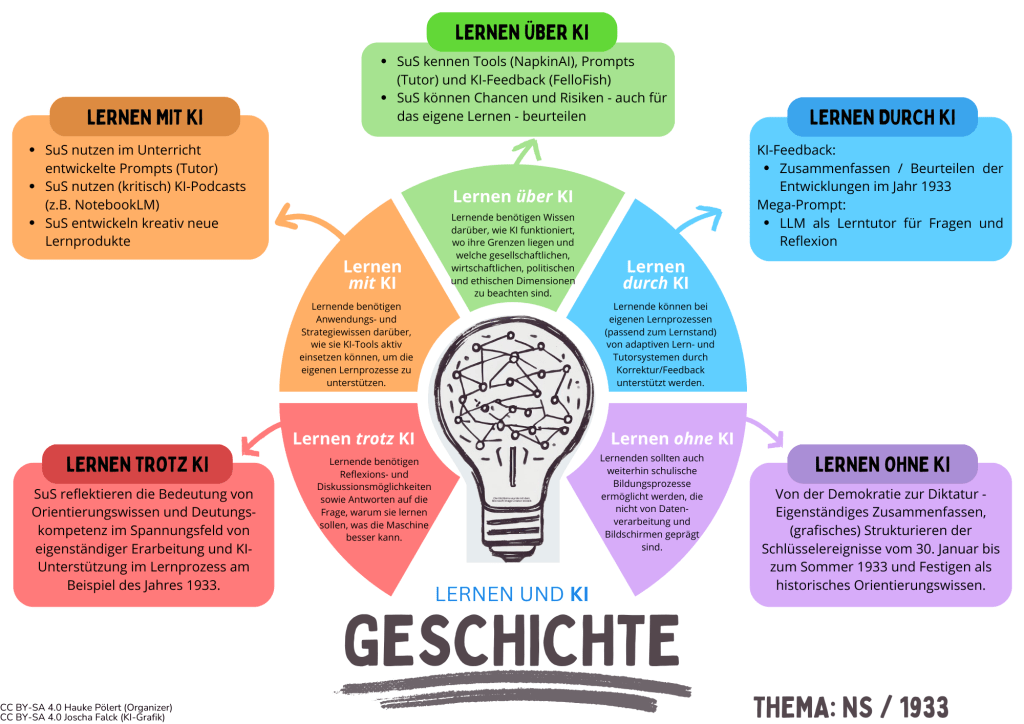

Schon an der Struktur lässt sich erkennen: Dieser Beitrag ist Teil meines eigenen Reflexionsprozesses und der Versuch einer Einordnung und Momentaufnahme. Dabei helfen mir auch intensive Gespräche und Feedback-Runden mit den Schülerinnen und Schüler meiner Geschichtskurse, aus denen das untenstehende Reflexionsposter entstand – das also sowohl meine als auch die Sicht der Schülerinnen und Schüler widerspiegelt.

Das Poster basiert auf den „5 Dimensionen Lernen und KI” von Joscha Falck mit dem Ziel, Lernanlässe über, mit und durch KI zu initiieren, zugleich aber auch Lerngelegenheiten trotz und ohne KI schaffen. Ich nutze diese Vorlage insbesondere für schulinterne Fortbildung im Rahmen von Pädagogischen Tagen, um eigene Erfahrungen zu bündeln, Unterrichtsentwicklung in Zeiten von KI zu reflektieren und mögliche Entwicklungsziele zu planen. Inzwischen finden die 5 Dimensionen aber auch immer häufiger im eigenen Unterricht Verwendung, so wie im hier gezeigten Beispiel aus meinem Grundkurs Geschichte der 13. Klasse, der die Frage des Lernens mit, über, trotz und ohne KI differenziert beurteilte:Mit Blick auf das Jahr 1933 und die politischen Prozesse zwischen Januar und Juli 1933 hatte die Unterrichtssequenz mithilfe unterschiedlicher Zugänge die Frage verfolgt, wie aus einer Demokratie innerhalb kürzester Zeit eine totale Diktatur werden konnte. Im Zentrum der Abschlussreflexion stand kurz vor dem Abitur 2025 das im Kurs fest etablierte Lernen mit und über KI, insbesondere aber die Frage danach, was ohne KI und eigenständig erarbeitet und gelernt werden sollte und warum Schülerinnen und Schüler im Geschichtsunterricht diese Zusammenhänge auch trotz KI weiterhin lernen (sollten).

Im Gespräch betonten die Schülerinnen und Schüler, wie wichtig historisches Orientierungswissen durch eigenständige Erarbeitung ist und auch trotz KI bleibt – und dass sie zugleich sehr gerne die neuen Möglichkeiten für ihr Lernen und Arbeiten nutzen. Das Sammeln gemeinsamer Erfahrungen, der Austausch auf Augenhöhe und das Aushandeln neuer Anforderungen an Lernprozesse werden im Fach Geschichte, wie in den meisten Schulfächern, zentral für gutes Lernen zwischen KI-Hype und KI-Skepsis.

Die erste Version dieses Textes ist am 12.08.2025 im PlanBD – dem Online-Magazin des Forum Bildung Digitalisierung – erschienen. Wer PlanBD noch nicht kennt, sollte unbedingt einmal reinschauen: Unter den Rubriken „Haltung“, „Lehren und Lernen“ und „Rahmenbedingungen bietet PlanBD fundierte Beiträge zu Schule in der Digitalität.